OTel

OpenTelemetry (OTel) 是一个开源项目,旨在为分布式系统(如微服务架构)中遥测数据的收集、处理和导出提供厂商中立的标准。它帮助开发者更轻松地分析软件的性能和行为,从而促进应用问题的诊断和解决。

术语

前提条件

-

确保存在可用的 ALB:创建或使用已有的 ALB,本文档中 ALB 名称用

<otel-alb>代替。有关创建 ALB 的操作步骤,请参见 Configure ALB。 -

确保有 OTel 数据上报服务器地址:该地址下文称为

<jaeger-server>。

操作步骤

更新 ALB 配置

-

在集群的 Master 节点,使用 CLI 工具执行以下命令编辑 ALB 配置。

-

在

spec.config部分添加以下字段。完成后的示例配置:

-

执行以下命令保存更新。更新后,ALB 默认启用 OpenTelemetry,所有请求的 Trace 信息将上报至 Jaeger Server。

相关操作

在 Ingress 中配置 OTel

-

启用或禁用 Ingress 上的 OTel

通过配置是否启用 Ingress 上的 OTel,可以更好地监控和调试应用的请求流,追踪请求在不同服务间的传播,定位性能瓶颈或错误。

操作步骤

在 Ingress 的 metadata.annotations 字段下添加如下配置:

参数说明:

- nginx.ingress.kubernetes.io/enable-opentelemetry:设置为

true表示 Ingress 控制器在处理该 Ingress 的请求时启用 OpenTelemetry 功能,即会收集并上报请求的 Trace 信息。设置为false或移除此注解,则不收集或上报请求 Trace 信息。

- nginx.ingress.kubernetes.io/enable-opentelemetry:设置为

-

启用或禁用 Ingress 上的 OTel Trust

OTel Trust 决定 Ingress 是否信任并使用来自请求的 Trace 信息(如 trace ID)。

操作步骤

在 Ingress 的 metadata.annotations 字段下添加如下配置:

参数说明:

- nginx.ingress.kubernetes.io/opentelemetry-trust-incoming-span:设置为

true时,Ingress 会继续使用已有的 Trace 信息,有助于保持跨服务追踪的一致性,使整个请求链路能在分布式追踪系统中完整追踪和分析。设置为false时,会为请求生成新的追踪信息,可能导致请求进入 Ingress 后被视为新的追踪链,打断跨服务追踪的连续性。

- nginx.ingress.kubernetes.io/opentelemetry-trust-incoming-span:设置为

-

在 Ingress 上添加不同的 OTel 配置

该配置允许针对不同的 Ingress 资源自定义 OTel 的行为和数据导出方式,实现对各服务追踪策略或目标的精细化控制。

操作步骤

在 Ingress 的 metadata.annotations 字段下添加如下配置:

参数说明:

- exporter:指定如何将采集到的 Trace 数据发送到 OTel Collector(OTel 数据上报服务器)。

- address:指定 OTel Collector 的地址。

- request_timeout:请求超时时间。

在应用中使用 OTel

以下配置展示了完整的 OTel 配置结构,可用于定义如何启用和使用应用中的 OTel 功能。

在集群 Master 节点,使用 CLI 工具执行以下命令获取完整的 OTel 配置结构。

返回结果:

参数说明:

继承关系

默认情况下,如果 ALB 配置了某些 OTel 参数且 FT 未配置,则 FT 会继承 ALB 的参数作为自身配置;即 FT 继承 ALB 配置,而 Rule 可以继承 ALB 和 FT 的配置。

-

ALB:ALB 上的配置通常是全局默认配置,可在此配置全局参数如 Collector 地址,供下层 FT 和 Rule 继承。

-

FT:FT 可继承 ALB 配置,未配置的 OTel 参数将使用 ALB 配置。但 FT 也可进一步细化配置,例如可选择性地启用或禁用 FT 上的 OTel,而不影响其他 FT 或 ALB 的全局设置。

-

Rule:Rule 可继承 ALB 和 FT 的配置,但也可进一步细化配置,例如某条 Rule 可选择不信任传入的 OTel Trace 信息,或调整采样策略。

操作步骤

通过在 ALB、FT 和 Rule 的 YAML 文件中配置 spec.config.otel 字段,添加 OTel 相关配置。

附加说明

采样策略

Attributes

-

Resource Attributes

这些属性默认上报。

-

Span Attributes

-

默认上报的属性:

-

默认上报但可通过修改 flag.hide_upstream_attrs 字段排除的属性:

-

默认不上报但可通过修改 flag.report_http_request_header 字段上报的属性:

-

默认不上报但可通过修改 flag.report_http_response_header 字段上报的属性:

-

配置示例

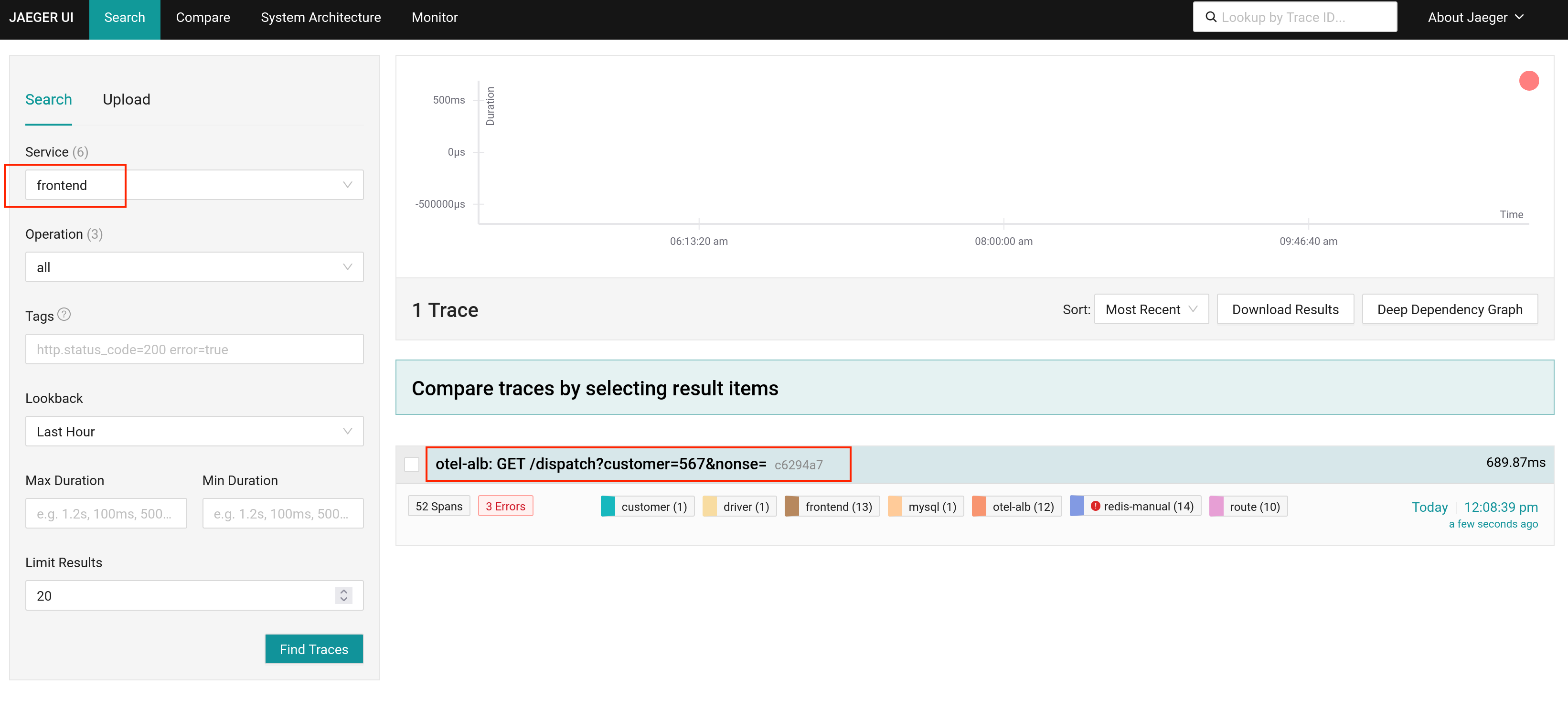

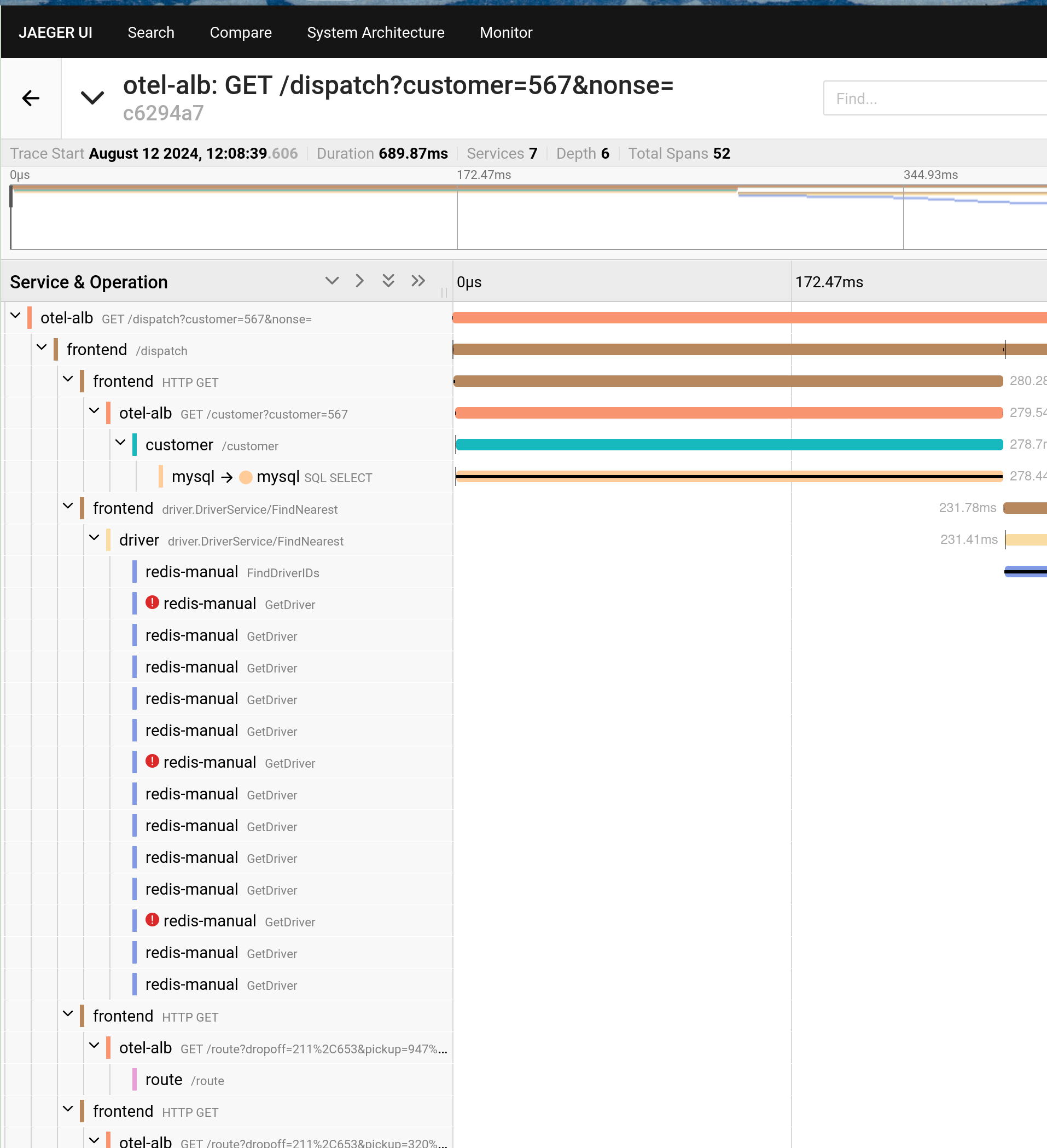

以下 YAML 配置部署了一个 ALB,并使用 Jaeger 作为 OTel 服务器,Hotrod-proxy 作为示范后端。通过配置 Ingress 规则,当客户端请求 ALB 时,流量将转发至 HotROD。同时,HotROD 内部微服务间的通信也通过 ALB 路由。

-

将以下 YAML 保存为名为 all.yaml 的文件。

-

在 CLI 工具中执行以下命令,部署 Jaeger、ALB、HotROD 及所有测试所需的 CR。

-

执行以下命令获取 Jaeger 的访问地址。

-

执行以下命令获取 otel-alb 的访问地址。

-

执行以下命令通过 ALB 向 HotROD 发送请求,此时 ALB 会将 Trace 上报至 Jaeger。

-

打开第 步骤 3 中获取的 Jaeger 访问地址查看结果。