架构#

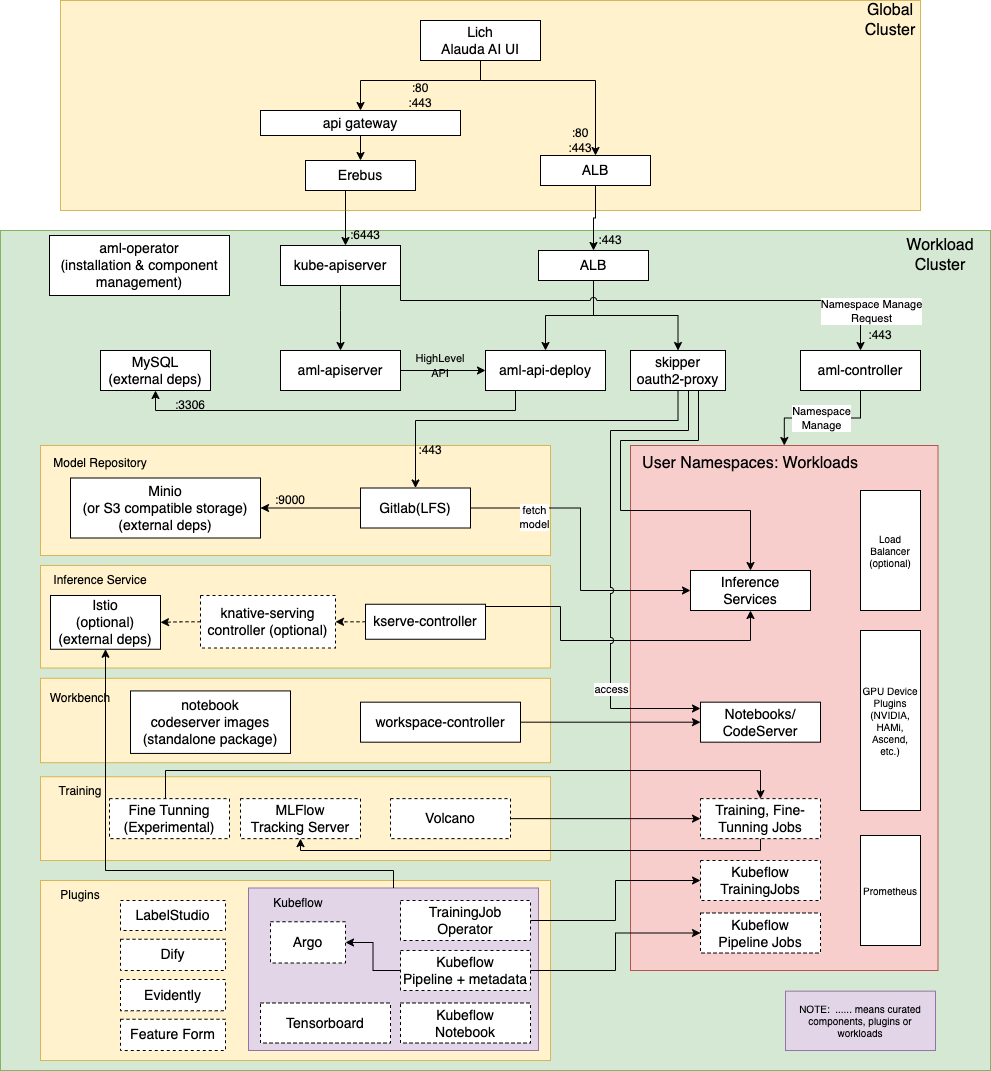

下图展示了 Alauda AI 平台的架构。

注意:Alauda AI 使用了一些通用的 Kubernetes、ACP 组件,包括:

- ALB

- Erebus

- kube-apiserver(kubernetes 组件)

| 组件 | 描述 | 类型 | 许可证 |

|---|---|---|---|

| Lich | Alauda AI UI 控制台 | 自研 | |

| aml-operator | 管理 Alauda AI 组件的安装和生命周期 | 自研 | |

| aml-apiserver | 扩展 kubernetes api-server 并为 Alauda AI API 访问提供授权增强 | 自研 | |

| skipper & oauth2-proxy | 代理来自 global 集群到工作负载集群的流量。流量通过 oauth2-proxy 进行认证 | 开源 | Apache 2.0 版本 |

| aml-controller | 管理工作负载集群上的 Alauda AI 命名空间。命名空间将自动配置模型仓库空间及相应资源。 | 自研 | |

| aml-api-deploy | 为 “Lich” 提供高级 API | 自研 | |

| Gitlab (with Minio or S3) | 模型仓库后端存储和版本跟踪 | 开源 | MIT |

| kserve-controller | (可选启用 knative serving 和 istio)管理 AI 推理服务及推理服务运行时 | 开源 | Apache 2.0 版本 |

| workspace-controller | 管理工作台实例(jupyter notebooks, codeserver) | 开源 | Apache 2.0 版本 |

| Volcano | 为 AI 训练作业提供协同调度(gang-scheduling)功能的插件。同时管理 “volcanojob” 资源以运行通用训练工作负载。 | 开源 | Apache 2.0 版本 |

| MLFlow | 通过存储和可视化指标及工件来跟踪训练和评估作业 | 开源 | Apache 2.0 版本 |

| Fine Tuning | 提供无代码 LLM 微调作业创建和管理的实验性 UI | 自研 | |

| Kubeflow | 提供 MLOps 功能的开源插件,包括:Notebooks、Tensorboard、Kubeflow pipeline、训练 operator。 | 开源 | Apache 2.0 版本 |

| Label Studio | 用于数据集标注的开源插件 | 开源 | Apache 2.0 版本 |

| Dify | 用于通过 Web UI 创建 LLM Agents、RAG 应用的开源插件 | 开源 | <br>a modified version of the Apache License 2.0<br> |

| Evidently | 用于监控在线推理服务性能和数据漂移的开源插件 | 开源 | Apache 2.0 版本 |

| GPU device plugins | HAMi 和 nvidia GPU 设备插件 | 开源 | Apache 2.0 版本 |